- ▶ Management de l'entreprise

- Conception de la stratégie

- Principes de gouvernance

- La Performance des métier

- Le contrôle de gestion

- ▶ Innover en équipe

- L'Innovation et la Performance

- L'Innovation Managériale

- La Méthode SOCRIDE

- ▶ Décider au quotidien

- Le processus de Décision

- La Décision en équipe

- Les Techniques de décision

- ▶ Guide gratuit de l'Autoformation

- Méthode d'autoformation

- Les 7 Qualités pour réussir

- Comment s'auto-évaluer ?

- ▶ Formation Gratuite Management

- Formation tableau de bord et BI

- Formation Management de Projet

- Formation Entrepreneuriat

- ▶ ebook et PDF management gratuits

- ▶ PDF Entrepreneuriat

- ▶ ebook Perfonomique

Les bases de données In-Memory

Une nouvelle génération de base de données pour une utilisation intensive

Comme son nom l'indique clairement, une base de données dite "In memory" est essentiellement résidente en mémoire vive.

Comme son nom l'indique clairement, une base de données dite "In memory" est essentiellement résidente en mémoire vive. Cette nouvelle génération profite de la baisse du prix des mémoires vives et de la puissance de calcul offerte par les nouvelles générations de processeurs multi-coeurs. En limitant au maximum les accès disques, les requêtes s'exécutent en un temps record.

C'est évidemment une avancée majeure pour le monde de la business intelligence en version analytique. L'analyste n'est plus gêné par la lenteur des accès à l'infrastructure et aux disques de stockage pour bâtir de solides modèles d'analyses.

Le principe mis en oeuvre

Les bases de données "In Memory" sont généralement construites comme des base relationnelles. Elles sont conformes aux exigences ACID (Atomicity, Consistency, Isolation, Durability) qui garantissent l'intégrité des transactions. Les données contenues en mémoire sont volatiles par principe. Un système de sauvegarde périodique par image disque, snapshot, permet de sauvegarder la base. Ce système est complété d'une historisation des transactions afin de remettre la base en état en cas de coupure de courant.Les solutions du marché

Sans surprise, la grande majorité des éditeurs de bases de données ont lancé leur propre solution.- SAP AG propose le produit Hana ®

SAP place le In Memory au coeur de sa stratégie et multiplie les annonces. Le serveur Hana est désormais pleinement opérationnel avec la suite ERP de l'éditeur afin d'accélérer au maximum les transactions. À ce titre, l'éditeur parle de temps réel. SAP hana site officiel - Oracle Corp et le produit Exalytics &Reg;

Directement concurrent du produit Hana, Exalytics est selon son éditeur plus orienté analytique que transactionnel. Oracle Exalytics site officiel - SAS Corp propose SAS® In-Memory Analytics SAS In-Memory Analytics site officiel

- Microsoft a aussi lancé le projet baptisé "Hekaton ®" dans un premier temps, intégré à SQL Server Microsoft OLTP In-Memory SQL Server 2016 site officiel

La technologie mise en oeuvre

À titre d'exemple de la puissance dédiée à une base de données de type In Memory, attardons-nous sur la solution choisie par Oracle Corp avec le produit Exalitics ®. Cette solution s'appuie sur un serveur Fujitsu ® doté de 4 téraoctets de RAM et de 4 processeurs SPARC64 de 16 cœurs chacun.D'autres, comme SAS Corp, ont opté pour une architecture de type big data reposant sur une infrastructure Hadoop de 96 serveurs (blade servers), soit 1.152 coeurs, 9,2 téraoctets de mémoire et 57,6 téraoctets de capacité de stockage sur disque.

L’auteur

Alain Fernandez est un spécialiste de la mesure de la performance et de l’aide à la décision. Au fil de ces vingt dernières années, il a accompagné nombre d'entreprise en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème et connexes, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités.

Alain Fernandez est un spécialiste de la mesure de la performance et de l’aide à la décision. Au fil de ces vingt dernières années, il a accompagné nombre d'entreprise en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème et connexes, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités. À ce sujet, voir aussi

À ce sujet, voir aussi

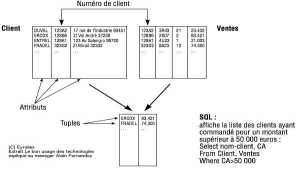

- Les bases de données relationnelles, SGBDR

Définition, historique et principe des bases de données relationnelles qui représentent encore aujourd'hui la très large majorité des SGBD d'entreprise.Modèle ACID, triggers, procédures stockées, verrou et Deadlock.

Définition, historique et principe des bases de données relationnelles qui représentent encore aujourd'hui la très large majorité des SGBD d'entreprise.Modèle ACID, triggers, procédures stockées, verrou et Deadlock. - Bases de données NoSQL, le principe

Que sont les bases de données Not only SQL ? Quelles sont les applications où elles s'avèrent plus performantes que les bases de données relationnelles SGBD-R ? Voyons tout cela...

Que sont les bases de données Not only SQL ? Quelles sont les applications où elles s'avèrent plus performantes que les bases de données relationnelles SGBD-R ? Voyons tout cela... - Excel et la Business Intelligence

Quels sont les avantages et les inconvénients d'utiliser Excel comme outil utilisateur de la Business intelligence ? Excel est en effet devenu au fil du temps un outil Business Intelligence à part entière. Voir notamment Power Pivot et Power View.

Quels sont les avantages et les inconvénients d'utiliser Excel comme outil utilisateur de la Business intelligence ? Excel est en effet devenu au fil du temps un outil Business Intelligence à part entière. Voir notamment Power Pivot et Power View.

À lire...

À lire...

Le livre de référence du site

Le livre de référence du site

Les nouveaux tableaux de bord des managers

Les nouveaux tableaux de bord des managers

Le projet Business Intelligence en totalité

Alain Fernandez

Éditions Eyrolles 6ème édition

Disponible en librairie

›

www.amazon.fr

PDF & ePub

Kindle

![]() Voir ici la fiche technique, extraits, critiques...

Voir ici la fiche technique, extraits, critiques...

Piloter l'Entreprise Innovante...

Piloter l'Entreprise Innovante...

Avez-vous déjà essayé d'instaurer la prise de décision en équipe ? Sans précautions préalables, rapidement, le consensus le plus mou qui soit vient casser les plus pures ambitions. Mais connaissez-vous la méthode SOCRIDE centrée sur les questions incontournables de Confiance et de Reconnaissance ? Rien de plus facile ! Elle est expliquée, illustrée et détaillée dans ce livre :

Les tableaux de bord du manager innovant

Les tableaux de bord du manager innovant

Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Alain Fernandez

Éditeur : Eyrolles

Pages : 320 pages

![]() Consultez la fiche technique »»»

Consultez la fiche technique »»»

Pour acheter ce livre :

Format ebook : PDF & ePub,

Format Kindle

Voir aussi...

Les fiches du dossier: Big Data

Bases de données NoSQL, le principe

Bases de données NoSQL, le principe

Que sont les bases de données Not only SQL ? Quelles sont les applications où elles s'avèrent plus performantes que les bases de données ... Meilleurs livres du Big Data

Meilleurs livres du Big Data

Les livres de référence Big Data et machine learning, sept ouvrages pour bien comprendre les principes et les enjeux. Les quelques livres consacrés ... Quelles sont les limites du Big Data et de l'Analytique ?

Quelles sont les limites du Big Data et de l'Analytique ?

Le Big Data offre bien des avantages sur le papier. Dans la réalité, le Big Data n'est pas exempt de limites qu'il s'agit de bien connaître avant ... Formation Big Data en ligne

Formation Big Data en ligne

Formation au Big Data. Un guide d'autoformation disponible en ligne à l'usage des managers qui n'ont guère le temps d'investir dans un programme ... Un regard critique du Big Data

Un regard critique du Big Data

Le Big Data est une révolution en soi, aucun doute à ce sujet. Cela dit en pratique, il ne faut pas non plus dire et faire n'importe quoi. Pour ... Le big data et la décision en entreprise

Le big data et la décision en entreprise

Les apports du big data au processus décisionnel en entreprise, des changements en perspective... Qu'est-ce que le Big Data ? Définition et Principe

Qu'est-ce que le Big Data ? Définition et Principe

Le Big Data, la solution miracle à tous nos problèmes ? Sans dénigrer les avantages indéniables de cette révolution technologique, il est ... Le Big Data expliqué: Quoi ? Pourquoi ? Comment ?

Le Big Data expliqué: Quoi ? Pourquoi ? Comment ?

Le big data expliqué aux managers en 3 questions/réponses : Quoi ? Pourquoi ? et Comment ? Bref tout ce qu'il s'agit de savoir afin ... MapReduce, définition

MapReduce, définition

MapReduce est un modèle de programmation massivement parallèle adapté au traitement de très grandes quantités de données. Les programmes adoptant ... Hadoop, définition

Hadoop, définition

Hadoop est un projet Open Source géré par Apache Software Fundation basé sur le principe Map Reduce et Google File System, deux produits Google ... La technologie mise en oeuvre pour le Big Data

La technologie mise en oeuvre pour le Big Data

Les technologies qui permettent de bâtir une solution de type Big Data ou Données Massives en français, ont leur origine au sein même des moteurs ... Comment tout résoudre avec le Big Data ?

Comment tout résoudre avec le Big Data ?

Attention aux vendeurs d'illusions ! Le marketing et son storytelling sont -en marche- pour colporter les nouvelles chansons de gestes contant les ...

Partagez cet article...

Partagez cet article...

(total partages cumulés > 85)

Du même auteur

Décider en équipe

Tableau de bord DIY

Bonnes pratiques projet

Le système décisionnel

Les plus lus...

1. Business Intelligence, les perspectives

1. Business Intelligence, les perspectives Les perspectives de la Business Intelligence, 1ère partie, ce que n'est pas la Business Intelligenc...

2. Méthodes et outils d'analyse de la Business Intelligence

3. Modélisation du data warehouse, le schéma en étoile