- ▶ Management de l'entreprise ▶ Management Démocratique

- Conception de la stratégie

- Principes de gouvernance

- La Performance des métier

- Le contrôle de gestion

- ▶ Innover en équipe

- L'Innovation et la Performance

- L'Innovation Managériale

- La Méthode SOCRIDE

- ▶ Décider au quotidien

- Le processus de Décision

- La Décision en équipe

- Les Techniques de décision

- ▶ Guide gratuit de l'Autoformation

- Méthode d'autoformation

- Les 7 Qualités pour réussir

- Comment s'auto-évaluer ?

- ▶ Formation Gratuite Management

- Formation tableau de bord et BI

- Formation Management de Projet

- Formation Entrepreneuriat

- ▶ ebook et PDF management gratuits

- ▶ PDF Entrepreneuriat

- ▶ ebook Perfonomique

Comment utiliser Google pour se former seul à moindre coûts ?

« Don't be evil. » Ne soyez pas malveillants. Il est possible de gagner de l'argent sans vendre son âme au diable. Devise originelle de Google Corp.

Objectif de cette fiche pratique

Mieux comprendre le principe des algorithmes des moteurs de recherche pour mieux sélectionner les résultats proposés lors d'une session de formation.Conseil : La meilleure méthode pour comprendre les moteurs de recherche consiste simplement à les tester soi-même, en utilisant diverses requêtes sur un thème que l'on connaît parfaitement bien, et en comparant les résultats proposés.

Risques d'échec : Se laisser séduire par les discours de performance et de pertinence absolue et se contenter des premiers résultats proposés par le moteur de recherche.

Google, dénicher L'information perdue dans le bruit ambiant

L'idée très largement admise où nous serions tous surinformés n'est qu'une illusion. L'information pertinente existe, mais elle est noyée dans un bruit toujours plus assourdissant d'anecdotes insignifiantes, de distractions dérisoires et de… messages publicitaires ! Le web tend à devenir une immense galerie commerciale, et toutes les techniques marketing pour nous pousser à consommer ont pris le pas sur le partage de l'information.

L'idée très largement admise où nous serions tous surinformés n'est qu'une illusion. L'information pertinente existe, mais elle est noyée dans un bruit toujours plus assourdissant d'anecdotes insignifiantes, de distractions dérisoires et de… messages publicitaires ! Le web tend à devenir une immense galerie commerciale, et toutes les techniques marketing pour nous pousser à consommer ont pris le pas sur le partage de l'information.

Peut-on encore faire confiance aux moteurs de recherche, et Google en particulier, pour dénicher l'information qui nous convient ? Il faut surtout apprendre à mieux les connaître, et prendre conscience que ces moteurs incontournables sont la propriété d'entreprises commerciales dont les finalités ne sont peut-être pas toujours en accord avec notre besoin d'autoformation. C'est ainsi que l'on pourra un peu mieux les domestiquer et en tirer un profit appréciable. Voir aussi Savoir un peu de tout sur tout.

Google, le moteur de recherche préféré des francophones

En France, Google phagocyte largement plus de 90 % de part de marché des moteurs de recherche . Bing de Microsoft et Yahoo se partagent le reste. Les « outsiders » tel DuckduckGo ne sont pas encore suffisamment pertinents dans leur version francophone pour espérer trouver leur place parmi les outils privilégiés des français.Les solutions purement franco-françaises telles que Qwant rencontrent bien des difficultés pour dépasser le succès d'estime. Aussi nous concentrons notre étude sur le moteur de recherche Google. Cela dit, les critiques et commentaires formulés ici sont tout aussi valables pour les autres moteurs de recherche commerciaux.

Google, Un outil de confiance ?

La large majorité des internautes accordent une confiance absolue aux moteurs de recherche tels que Google. En effet, selon de multiples études régulièrement mises à jour, plus de 90 % des internautes ne dépassent jamais la première page et se limitent aux premiers résultats proposés. Un comble dans le cadre d'une formation !Pourtant Google tout comme Bing ou Yahoo se trompent parfois et n'évitent pas toujours les contresens. Dans le pire des cas, ils relaient malgré eux les thèses les plus absurdes et contribuent ainsi à la désinformation généralisée.

Un exemple de désinformation

Fin 2016, le périodique britannique The Guardian a ainsi épinglé Google . À la question « L'holocauste a-t-il eu lieu ? », le moteur de recherche propose en premières positions rien de moins que des sites révisionnistes. Bien évidemment, les équipes de Google se sont empressées de corriger « manuellement » cette aberration.Mais qu'en est-il pour toutes les autres questions qui ne sont pas passées par la moulinette d'un grand quotidien ? Cette erreur gravissime n'est pas un cas isolé.

En France, ce sont les sites d'associations extrémistes anti-avortement que le moteur de recherche a longtemps plébiscités au détriment des sites institutionnels, là encore malgré lui.

Google est un indispensable outil pour rechercher l'information pertinente, notamment dans le cadre d'une autoformation. Encore faut-il bien connaître son principe pour débusquer les bons documents d'intérêt qui, à coup sûr, nous échapperons si l'on s'en tient à une utilisation trop basique.

Le principe fondateur : la foi dans l'algorithme

Les principaux moteurs de recherche actuels partagent le même principe fondateur :- Quel que soit le thème, la qualité d'un article dépend de critères précis mathématisables.

Il est aussi vrai que pour modérer un tant soit peu le comportement trop robotisé de ses algorithmes, Google s'appuie sur des techniques d'auto-apprentissage fondées sur l'expérience utilisateur. Autrement dit, les algorithmes de recherche bâtissent leurs processus de tri et de sélection en s'inspirant des pratiques humaines.

Vu la taille du web actuel, il n'est guère concevable de procéder différemment. D'ailleurs, les grands annuaires de sites entièrement élaborés manuellement ont aujourd'hui tous disparu.

Yahoo, Voilà, Nomade et Dmoz, l'Open Directory Project, pour ne citer que ceux-ci, avaient construit le succès du web avant d'être phagocytés par Google et le concept de moteur de recherche universel.

Pour bien comprendre le principe de production des résultats automatisés, commençons par étudier le fameux PageRank , l'algorithme « historique » de classement qui fit le succès de Google. Même s'il est aujourd'hui moins mis en avant, c'est toujours une brique fondatrice du moteur de recherche.

1. L'algorithme « PageRank »

Le « PageRank » est le plus connu des algorithmes de tri du moteur de recherche. Il s'agit à l'origine d'une méthode assez ancienne de classement des documents scientifiques par ordre d'importance. Le principe de base, ici brièvement résumé, est assez simple à comprendre.

Dans la grande masse des documents accessibles sur le web, certains d'entre eux disposent par essence d'une notoriété évidente. Les articles de fond publiés dans une revue scientifique de renom, ou par un organisme public, une université ou un centre de recherche, bénéficient en toute logique de cet avantage et sont attribués d'un avis positif a priori pour l'algorithme.

Si d'autres articles bénéficiant eux aussi d'un avis positif font référence à cet article, sa cote, le PageRank, gagne des points. Dans un contexte hypertexte, ces articles notoires pointent nécessairement vers d'autres articles hébergés par des sites moins renommés. Ces derniers sont alors à leur tour valorisés en partant du principe légitime que si des sites à la notoriété reconnue pointent sur un document précis, c'est bien parce qu'il est intéressant.

De même, un document ou une page web recevant un grand nombre de liens provenant de sites d'intérêt traitant du même sujet ou d'un sujet connexe voit théoriquement sa cote grimper dans l'échelle de qualité des moteurs de recherche.

En conclusion, plus un document ou plutôt une page web est populaire, plus elle a de chance d'être plébiscitée par le moteur de recherche.

Toute médaille a son revers : l'algorithme du PageRank est un frein à l'originalité

En effet, le PageRank n'est autre qu'une récompense à la citation. Une page web gagne en notoriété si d'autres sites renommés pointent sur cette même page. Autrement dit, plus une page est citée par des sites notoires de préférence, plus elle a de chances d'apparaître en tête de liste.A contrario, une thèse plus originale et donc moins connue, c'est-à-dire peu référencée par d'autres sites, restera dans les tréfonds du web. Elle aura peu de chance d'apparaître en tête des résultats.

2. Les algorithmes « qualité »

L'algorithme du PageRank n'est pas le seul algorithme de Google, tant s'en faut. Google dispose d'une multitude d'algorithmes pour étudier le contenu du document et ainsi mieux répondre aux interrogations des internautes.Pour juger de la pertinence d'un document en fonction de la question posée, Google analyse le texte selon des critères bien spécifiques tels que la syntaxe, la structure du document, la présence des mots-clés et leurs fréquences, ainsi que bien d'autres paramètres non dévoilés.

La critique : Les résultats sont aussi manipulables

Le métier de SEO, Search Engine Optimizer, est en plein essor. Ces professionnels ont pour vocation d'optimiser la réalisation des sites web, afin d'améliorer sensiblement leur classement dans les pages de résultats des moteurs de recherche.

En effet, puisque neuf internautes sur dix ne cherchent pas plus loin que les premiers résultats, pour un site web, il est d'un enjeu stratégique d'être présent dans le tiercé de tête.

Et ce n'est pas peu dire, des entreprises ont vu leur chiffre d'affaires fondre littéralement une fois leur site web relégué en deuxième page ou au-delà.

Les professionnels du référencement de site cherchent donc à identifier les critères de pertinence utilisés par Google pour tenter d'orienter les résultats à leur avantage. Ils parsèment les textes des bons mots-clés et créent des réseaux sophistiqués de liens avec d'autres sites web, de manière à accroître artificiellement la notoriété du site et tromper ainsi un tant soit peu les algorithmes de classement de Google.

3. Les algorithmes anti sur-optimisation

Pour conserver son pouvoir de jugement intact et lutter contre les stratégies élaborées par les experts SEO, Google a développé une batterie d'algorithmes bien spécifiques. Il s'agit en effet de mettre en défaut la large majorité des ruses exploitées par les « manipulateurs »

Une amélioration continue

Au fil des années, la pertinence du moteur de recherche s'est sérieusement améliorée. Désormais une large majorité des articles proposés en pole position respectent les règles de qualité les plus élémentaires autant sur le plan de la structure que de la pertinence selon la requête formulée. Mais, parce qu'il y a un « mais », un document bien structuré n'est pas nécessairement le plus intéressant.Le moteur de recherche n'a donc aucune idée du sujet traité ni de la pertinence réelle des articles sélectionnés comme « meilleurs choix », c'est-à-dire ceux qu'il classe en tête de la liste de résultats. Aussi, est-il prudent de maintenir son esprit critique en éveil et d'accorder une confiance « limitée » dans les résultats proposés par le moteur de recherche.

Dans la jungle du web, tous les moyens sont bons pour gagner des positions

Le web n'est plus un terrain de jeu pour amateur. Seuls les sites gérés par des professionnels parviennent désormais à tirer leur épingle du jeu, c'est-à-dire à apparaître en tête de la page de résultats pour les requêtes les plus concurrentielles.Google privilégie en effet les sites de taille conséquente qui enrichissent régulièrement leur contenu. Pour produire rapidement de nouveaux articles et conserver ainsi la pole position, bien des gestionnaires sans vergogne n'hésitent pas à recourir à des rédacteurs professionnels qui ne sont pas toujours des spécialistes du sujet traité. C'est actuellement l'un des principaux problèmes pour une autoformation sur le web.

Ces professionnels de la rédaction n'évitent pas non plus les contresens . Bien entendu, ils n'oublient pas d'insérer les mots-clés précisés dans le contrat pour soigner le positionnement de l'article dans la page des résultats de recherche.

Automatiser le plagiat: le pire est toujours possible

Il existe aussi une multitude d'agences web qui, pour rentabiliser au maximum les phases de création de contenu, n'hésitent pas à utiliser des outils de « content spinning » pour automatiser le plagiat. Ces outils exploitent des dictionnaires de synonymes et des listes de périphrases toutes prêtes pour contrefaire automatiquement et en toute discrétion des articles déjà présents sur le web.La critique : Le web tend à devenir la plateforme du sous-prolétariat internationalisé

Ces articles d'une bien pauvre qualité sont totalement inutiles. Ils envahissent le web et créent encore plus de confusion. Déjà, fin 2015, Gary Illyes, l'un des principaux communicants de l'entreprise Google, annonçait que 60 % du web n'était que de la copie et de la redondance d'informations . On comprend mieux pourquoi.

La complexité des algorithmes

Au fil du temps, les algorithmes de recherche ont atteint un degré de complexité quasiment incompatible avec la compréhension humaine. Selon les ingénieurs de Bing de Microsoft, bien peu de personnes de l'entreprise connaissent exactement le fonctionnement du coeur de l'algorithme. L'équipe de recherche de Google confirme le même constat. De toute façon, avec l'essor du machine learning, il sera d'ici peu humainement impossible de comprendre le fonctionnement interne des algorithmes de classement des résultats.Poursuivons l'étude critique avec l'aspect financier.

![]()

C'est en effet l'unique moyen de parvenir à une indispensable intelligence collective tout en répondant aux attentes des salariés qui pour la large majorité ne supporte plus d'être considéré comme un centre de coût, réduit "au mieux" à la portion congrue des succès.

Pourquoi oublie-t-on si facilement que ce sont eux les véritables créateurs de valeurs de l'entreprise ?

Dans cette étude, nous verrons comment bâtir concrètement avec exemples à l'appui une gouvernance coopérative digne de ce nom.

La transformation démocratique de l'entreprise

La transformation démocratique de l'entreprise

Pour en finir avec le mépris, principe délétère du management d'hier et d'aujourd'hui

Auteur : Alain Fernandez

Sujet : Une étude méthodique et illustrée d'implantation d'une gouvernance coopérative au sein d'une entreprise industrielle

Pages : 360 pages

ISBN : 978-2959320422

Dispo : Cliquez sur l'image

L’auteur

Alain Fernandez a formé au cours de sa carrière un bon nombre de managers et de futurs entrepreneurs. Il est l'auteur de plusieurs livres d'autoformation publiés aux Éditions Eyrolles, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités. Il offre sur le site www.piloter.org plusieurs ebooks gratuits.

Alain Fernandez a formé au cours de sa carrière un bon nombre de managers et de futurs entrepreneurs. Il est l'auteur de plusieurs livres d'autoformation publiés aux Éditions Eyrolles, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités. Il offre sur le site www.piloter.org plusieurs ebooks gratuits. A ce sujet, voir aussi

A ce sujet, voir aussi

google et le ciblage publicitaire

google et le ciblage publicitaire

Il est toujours utile de ne jamais perdre de vue que Google, Bing et les autres moteurs de recherche ne sont pas des organisations philanthropiques mais bien des entreprises commerciales. Sachant qu'elles vivent essentiellement de la publicité, le plus souvent ciblée selon votre profil et judicieusement glissée dans les résultats et au sein des sites à visiter, êtes-vous prêts à cliquer sur la première proposition sans chercher plus avant ? Alors dans quelle mesure peut-on faire confiance aux résultats proposés par les moteurs de recherche et Google en particulier ? Voyons tout cela d'un peu plus près. Guide pour une bonne utilisation de google

Guide pour une bonne utilisation de google

Quatre recommandation pour bien exploiter Google et les autres moteurs de recherche. Ces recommandations élémentaires et faciles à mettre en oeuvre n'ont d'autre finalité que d'orienter la prospection selon les réels besoins de l'internaute. Il est en effet préférable de ne pas se laisser abuser par les résultats proposés par le moteur de recherche comme pertinents par principe. C'est le troisième et dernier volet de notre enquête sur l'utilisation des moteurs de recherche et de Google en particulier. Qu'est-ce qu'un moteur de réponse ?

Qu'est-ce qu'un moteur de réponse ?

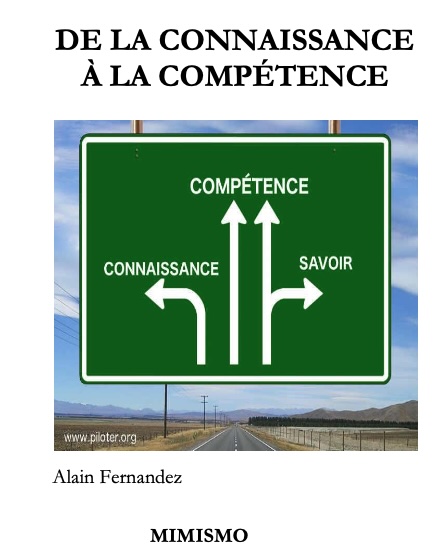

Jusqu'à présent, nous avions toujours considéré Google comme un moteur de recherche. À une requête donnée, le moteur de recherche délivre les pages des sites qui lui semblent les plus pertinentes au sens de ce qu'il comprend de la question posée et de ce qu'il sait de l'internaute. On observe depuis quelques années une tendance qui présage un changement radical. Google connaitrait la bonne réponse... Évaluer la pertinence des documents

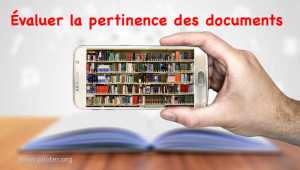

Évaluer la pertinence des documents

Recherche Documentaire : Il n'est pas aisé de juger à l'estime la pertinence des documents collectés. C'est là la principale difficulté de la recherche documentaire. Pour ne pas se trouver face à un dilemme dès que l'on déniche un document qui paraît sérieux, il est prudent d'établir un juste barème d'évaluation des sources auquel se référer. C'est grâce à cet outil d'aide à la décision que l'on évalue la qualité de chacune des pièces et que l'on choisit sans (trop de) regret entre je garde et je jette. Voyons comment réaliser ce crible.

À lire...

À lire...

Le livre de référence de l'auto-formation, maintenant disponible

RATTRAPER LE TEMPS PERDU SANS SE PRENDRE LA TÊTE

RATTRAPER LE TEMPS PERDU SANS SE PRENDRE LA TÊTELes 7 bonnes pratiques pour se former seul et sans contrainte ( ce sont aussi les miennes depuis bien longtemps)

Alain Fernandez

Format ebook (epub et kindle) 110 pages (équivalent papier)

Prix : 0 euros (cliquez sur la couv du livre)

ISBN : 9782959320446

Voir la fiche pratique Voir ici les livres de référence du management et de l'entrepreneuriat. Ces ouvrages complémentaires du site, peuvent être utilisés dans le cadre d'une autoformation :

Google-moi : La deuxième mission de l'Amérique

Google-moi : La deuxième mission de l'Amériquede Barbara Cassin

Albin Michel 258 pages

Prix : 17 Euros

Ce livre, pas très récent il est vrai, est particulièrement passionnant pour mieux comprendre la philosophie et les finalités de Google. À lire.

www.amazon.fr

Cet ouvrage de référence développe une démarche pratique pour dynamiser l'innovation dans une optique de performance globale et durable de l'entreprise en se fondant sur une délégation efficace auprès d'équipes de terrain solidaires.

Piloter donc au lieu de contrôler !, Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Piloter donc au lieu de contrôler !, Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Alain Fernandez

Editeur : Eyrolles

Pages : 320 pages

Prix : 25 Euros

Voir aussi...

Image Wikipedia : Par Version 1 by Nohat (concept by Paullusmagnus); Wikimedia. — File:Wikipedia-logo.svg as of 14 mai 2010T23:16:42, CC BY-SA 3.0, https://commons.wikimedia.org/w/index.php?curid=10337301

Partagez cet article...

Partagez cet article...

(total partages cumulés > 185)

Pour approfondir

Un Bonheur Imaginaire

Décider en équipe

Tableau de bord DIY

Le système décisionnel

Bonnes pratiques projet

De salarié à entrepreneur

Astuces Entrepreneur

PDF Management

Les plus lus...

1. Google, la publicité et le ciblage des individus

1. Google, la publicité et le ciblage des individus2. Q'est-ce que le web visible ? Pourquoi se contente-t-on de la première page de résultats