- ▶ Management de l'entreprise ▶ Management Démocratique

- Conception de la stratégie

- Principes de gouvernance

- La Performance des métier

- Le contrôle de gestion

- ▶ Innover en équipe

- L'Innovation et la Performance

- L'Innovation Managériale

- La Méthode SOCRIDE

- ▶ Décider au quotidien

- Le processus de Décision

- La Décision en équipe

- Les Techniques de décision

- ▶ Guide gratuit de l'Autoformation

- Méthode d'autoformation

- Les 7 Qualités pour réussir

- Comment s'auto-évaluer ?

- ▶ Formation Gratuite Management

- Formation tableau de bord et BI

- Formation Management de Projet

- Formation Entrepreneuriat

- ▶ ebook et PDF management gratuits

- ▶ PDF Entrepreneuriat

- ▶ ebook Perfonomique

Data Mining, explorer les données du Data Warehouse

Le Data Mining, qu'est-ce que c'est ?

1. Le diable est dans les détails.

2. C'est une erreur magistrale de théoriser avant de disposer des données. Sherlock Holmes.

C'est un outil d'exploration des données décisionnelles

Définition

Le Data Mining est en fait un terme générique englobant toute une famille d'outils facilitant l'exploration et l'analyse des données contenues au sein d'une base décisionnelle de type Data Warehouse ou DataMart.

Les techniques mises en action lors de l'utilisation de cet instrument d'analyse et de prospection sont particulièrement efficaces pour extraire des informations significatives depuis de grandes quantités de données.

À quoi ça sert ?

Principe

En peu de mots, l'outil de prospection Data Mining est à même de trouver des structures originales et des corrélations informelles entre les données.Il permet de mieux comprendre les liens entre des phénomènes en apparence distincts et d'anticiper des tendances encore peu discernables.

Comment on l'utilise ?

A contrario des méthodes classiques d'analyses statistiques, cet instrument d'analyse est particulièrement adapté au traitement de grands volumes de données.Avec l'augmentation de la capacité de stockage des supports informatiques, un maximum de renseignements seront captés, ordonnés et rangés au sein du Data Warehouse.

Comportement des acheteurs, caractéristiques des produits, historisation de la production, désormais plus rien n'échappe à la collecte.

Avec le Data Mining, ces "téra-nesques" bases de données sont exploitables. Par exemple, le data mining est particulièrement précieux pour les sites de commerce en ligne. Ainsi équipés, ils disposent de la capacité d'établir une segmentation particulièrement fine afin de mieux connaître les clients et de mieux cibler les offres promotionnelles. Le chiffre d'affaires s'en ressent assurément.

Comment ça marche ?

Les techniques mises en oeuvre

Différentes techniques sont proposées. Elles sont à choisir en fonction de la nature des données et du type d'étude que l'on souhaite entreprendre- Les méthodes utilisant les techniques de classification et de segmentation

- Les méthodes utilisant des principes d'arbres de décision assez proches des techniques de classification

- Les méthodes fondées sur des principes et des règles d'associations ou d'analogies

- Les méthodes exploitant les capacités d'apprentissage des réseaux de neurones

- Et pour les études d'évolution de populations, les algorithmes génétiques

- Algorithmes Naïve Bayes, séries chronologiques, régression linéaire...

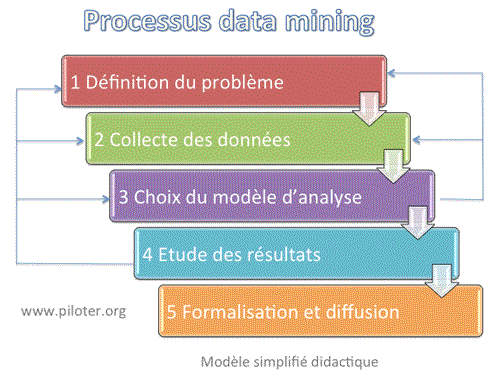

Le principe : une démarche (simplifiée et didactique) en 5 temps majeurs.

Définition du problème

Quel est le but de l'analyse, que recherche-t-on ? Quels sont les objectifs ? Comment traduire le problème en une question pouvant servir de sujet d'enquête pour cet outil d'analyse bien spécifique ? A ce sujet, se souvenir que l'on travaille à partir des données existantes, la question doit être ciblée selon les données disponibles.Collecte des données

Une phase absolument essentielle. On n'analyse que des données utilisables, c'est à dire "propres" et consolidées. On n'hésitera pas à extraire de l'analyse les données de qualité douteuse. Bien souvent, les données méritent d'être retravaillées. S'assurer au final que la quantité de données soit suffisante pour éviter de fausser les résultats. Cette phase de collecte nécessite le plus grand soin. Voir en seconde partie de l'article un cas concret de projet Datamining où la qualité de la collecte laisse un peu à désirer...Construire le modèle d'analyse

Ne pas hésiter à valider vos choix d'analyse sur plusieurs jeux d'essais en variant les échantillons. Une première évaluation peut nous conduire à reprendre les points 1 ou 2.Etude des résultats

Il est temps d'exploiter les résultats. Pour affiner l'analyse on n'hésitera pas à reprendre les points 1, 2 ou 3 si les résultats s'avéraient insatisfaisants.Formalisation et diffusion

Les résultats sont formalisés pour être diffuser. Ils ne seront utiles qu'une fois devenus une connaissance partagée. C'est bien là l'aboutissement de la démarche. C'est aussi là que réside la difficulté d'interprétation et de généralisation...

4 conseils complémentaires

-

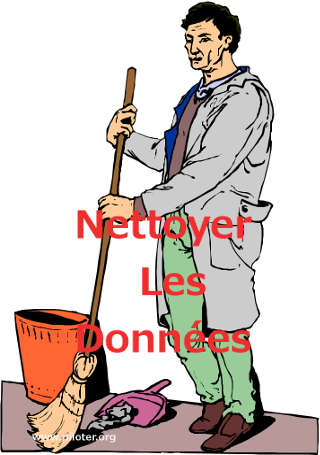

Accordez le soin nécessaire à la phase de collecte des données

La collecte des données est une étape fondamentale. Elle est longue et coûteuse. Il est indispensable de disposer de la garantie de la fiabilité des données avant de lancer la moindre analyse. L'étude des résultats mérite toute votre attention

Il ne faut pas hésiter à présenter différemment le problème et à tester d'autres techniques d'analyse avant de s'engager sur un résultat.Cet instrument n'est pas non plus un oracle absolu

Une absence de réponse du système ne doit pas être systématiquement considérée comme une négation. Il faut quelquefois prendre la précaution d'aborder le problème sous un autre angle avant de s'engager.Se souvenir qu'identifier une corrélation ce n'est pas nécessairement découvrir une nouvelle causalité

- Lire à ce sujet l'article : Corrélation n'est pas causalité

Quelques produits types représentatifs

- IBM Cognos IBM Cognos Analytics avec Watson

- SAS Enterprise Miner SAS® Enterprise Miner™

- Isoft Alice Data Science et analyse de données massives

- Statistica Data Miner sLe Data Mining avec STATISTICA Data Miner

- Oracle advanced analytic Data mining Oracle Data Miner

Principaux produits Open Source

- Weka de l'Université de Waikato New Zeland, Weka 3: Machine Learning Software in Java

- Rapid Miner The RapidMiner Platform

- Voir aussi Les outils d'exploration des données Data Mining Open Source

La Collecte des données ou de l'importance des préliminaires...

Si vous voulez faire parler le data mining, commencez donc par nettoyer vos données....

La phase la plus importante d'un projet se situe bien en amont du lancement proprement dit. On parle alors de l'avant-projet.

La phase la plus importante d'un projet se situe bien en amont du lancement proprement dit. On parle alors de l'avant-projet.

Cette caractéristique n'est pas propre aux projets technologiques. Lors de grands travaux de génie civil, le terrassement, la consolidation des sols, la préparation des fondations peuvent représenter une part importance du projet que ce soit en terme de coûts, de délais ou de compétences techniques à mobiliser.

La qualité de l'ouvrage dépendra directement du soin accordé à ces travaux préparatoires.

La phase la plus importante...

Dans le cadre d'un projet décisionnel, ce n'est pas la conception des interfaces utilisateurs mais bien les tâches de collecte, de nettoyage et de mise en forme des données qui constitueront le gros morceau, équivalent par analogie aux travaux de préparation des terrains du chantier de génie civil....Cette phase préalable peut représenter plus des ¾ des coûts et des délais globaux du projet. Et les compétences techniques à mettre en place ne seront pas en reste. Cette phase essentielle était il y a encore peu bien rarement estimée à sa juste valeur. Sa mésestimation est pourtant une des principales causes des échecs des projets décisionnels.

Pourquoi ?

Les entreprises n'ont que rarement conscience de la lourdeur des travaux à entreprendre pour transformer des données de terrain en informations utilisables au sein du processus décisionnel. Les données collectées au coeur des systèmes de production, même lorsque ceux-ci sont pleinement opérationnels, ne peuvent être utilisés telles quelles à des fins décisionnelles. Les données, dites de production, sont trop souvent imprécises et incohérentes voire erronées.D'autre part, l'analyse décisionnelle consiste essentiellement à rapprocher des données de sources différentes. Cette opération fondamentale n'est possible que lorsque les informations utilisent un même format et sont dans une logique similaire de gestion. Il est simplement dommage qu'il faille trop souvent se casser le nez sur cette problématique fondamentale avant d'en saisir la portée.

Le datamining en pratique, une expérience de terrain

L'entreprise K, leader de son créneau, est sur un marché particulièrement complexe en terme de clientèle. K en effet propose une gamme de produits couvrant autant les besoins des particuliers que des grands comptes.

Jusqu'à ce jour, l'approche commerciale était particulièrement cloisonnée, et seules les techniques de segmentation trouvaient grâce aux yeux de la direction.

Le nouveau responsable marketing a, à juste titre, souhaité moderniser les outils afin de « transversaliser » l'analyse et décloisonner un tant soit peu l'approche classique.

« Accédons à la connaissance "client", elle est déjà dans les tuyaux. »

Une rigoureuse démarche méthodologique

Il a donc entrepris la mise en place d'une solide infrastructure de type data Warehouse afin de collecter et de centraliser le maximum de données susceptibles de délivrer un enseignement...

Il a donc entrepris la mise en place d'une solide infrastructure de type data Warehouse afin de collecter et de centraliser le maximum de données susceptibles de délivrer un enseignement...Si la mise en place technique de l'infrastructure a été confiée à une entreprise spécialisée, l'alimentation de la base a, elle, profité des nombreuses demandes de stages étudiants qui ne manquent pas d'encombrer le bureau des responsables de RH.

C'est dire si la démarche a été morcelée.

Il était alors temps d'investir dans un outil de prospection performant de type data mining.

Bien que plus aisé d'utilisation que les classiques outils d'analyses statistiques, le data mining exige une rigoureuse démarche méthodologique si l'on souhaite en extraire un quelconque enseignement (définition du problème, délimitation des données de travail, choix de la méthode d'analyse...).

Il n'est pas superflu de se faire assister d'un consultant spécialiste de la question (celui qui m'a relaté cette anecdote que je publie avec son autorisation), histoire de domestiquer l'outil et d'exprimer correctement les préoccupations des demandeurs.

Quelle surprise, les résultats étaient particulièrement originaux !

Mais l'enthousiasme fut de courte durée.

Les résultats étaient surtout totalement incohérents.

« Y a quelque chose qui cloche... »

Il fallut alors dérouler de nouveau le fil et reprendre la procédure. Mêmes résultats. Tout aussi lamentables.

« C'est de la faute à qui ? »

Était-ce l'outil ? Était-ce le consultant ?

Il n'y a pas à tortiller, c'est la faute du consultant !

C'est là où ce dernier se retrouve au pied du mur. Car bien sûr les soupçons d'incompétence commencent à peser lourdement sur ses épaules.Vieux routier cependant, il ne perdit pas plus de temps et plongea la main au coeur même du système pour en extraire quelques données à fin d'analyse. Bien que la direction l'ait assuré de la qualité du travail de collecte, il savait d'expérience que les principaux problèmes venaient généralement de ce point précis.

A-t-il cependant à ce stade manqué de tact ? En tout cas lorsqu'il annonça que les données méritaient d'être « nettoyées », il découvrit jusqu'où pouvait se cacher la susceptibilité.

En fait non, le responsable, ce sont les données ou plutôt la collecte des données

« Nos données ne sont pas propres ? Il faudrait les nettoyer ? »

« Nos données ne sont pas propres ? Il faudrait les nettoyer ? »Il aurait mis en doute le soin corporel de ses interlocuteurs du style « À vue de nez, il est 5 heures », que la réaction n'aurait pas été plus épidermique. Il faut dire aussi à leur décharge que l'investissement global commençait à être conséquent. Ils auraient enfin voulu disposer des enseignements promis.

Une fois la tension un peu retombée, le consultant a pu démontrer calmement la source des problèmes. Bon gré mal gré, ses interlocuteurs se sont finalement ralliés à son analyse et ont alors investi ce qu'il fallait en terme de temps et de moyens pour accéder à une gestion de qualité des données décisionnelles. Je vous passe les détails de cette longue reprise.

On recommence... Et ça marche !

La procédure d'analyse a été relancée.

Et Bingo !

La boîte magique a parlé !

Des résultats tout à fait plausibles tombent !

« Ça à l'air bon ce coup-ci ! »

Plausibles ? Oui.

À peu de choses près, ils correspondaient aux attentes et étaient en accord avec les suppositions. Ils confirmaient les hypothèses et infirmaient les contre hypothèses soumises.

D'aucuns se sont d'ailleurs interrogés à haute voix sur l'intérêt de l'investissement.

« Tout ça, on le savait déjà... »

Ont-ils raison ?

Et d'après vous ?

Qu'en pensez vous ?

N'est-ce pas une information de choix que de voir se confirmer ses suppositions ?

Quitte à choisir, autant bâtir ses décisions sur des certitudes !

Une chose est certaine, on ne prend pas de décision à partir de suppositions. On bâtit difficilement une stratégie cohérente en se fondant sur des croyances et des « On dirait que ».Il est indispensable de diminuer le risque avant de s'engager sérieusement ; de s'éloigner du doute pour s'approcher de la certitude; de déplacer le curseur sur l'échelle des croyances depuis la vague impression jusqu'à "l'intime conviction". C'est aussi à cela que servent les outils d'aide à la décision dont le data mining fait partie.

Ensuite est-ce que l'investissement était rentable ? Question qui semblait être le corollaire de la précédente.

Pour cela il faut laisser passer un peu de temps, puis tenter de confronter la rentabilité des décisions prises en s'appuyant sur l'outil avec l'investissement proprement dit. En général, on se contente d'une appréciation à l'estime.

Une autre façon de faire serait d'apprécier le manque à gagner de la non décision.

Data Mining et Big Data

Le thème de la qualité des données est pleinement amplifié avec le phénomène Big Data. La qualité de la collecte sera toujours le parent pauvre du projet. Négliger la collecte des données et son contrôle qualité, ce n'est rien de moins que de tracer une voie royale vers un échec assuré. Attention au mythe de l'information "magique"

Attention au mythe de l'information "magique"

On apprend beaucoup de choses à étudier des données nombreuses, fiables et de qualité. On perçoit mieux le comportement des utilisateurs et des clients. Mais si les données révèlent plus ou moins clairement CE QUE font les clients, elles ne diront jamais POURQUOI ils le font, pourquoi ils agissent ainsi. C'est pourtant là que se trouve la clé d'un projet d'innovation réussi.

Encore aujourd'hui, bien des fournisseurs de solutions décisionnelles tentent d'attirer les plus crédules avec les mêmes slogans illusoires que ceux utilisés par les vendeurs de détecteur de métaux : "Vos données valent de l'or, apprenez à trouver la pépite qui s'y niche".

Alors faut-il s'équiper de poêle à frire pour trouver la fameuse pépite ?

La quête est aussi vaine que celle de notre prospecteur des temps modernes cité plus haut. Il n'y a pas de pépite.

L'information susceptible de déclencher la décision gagnante n'existe pas.

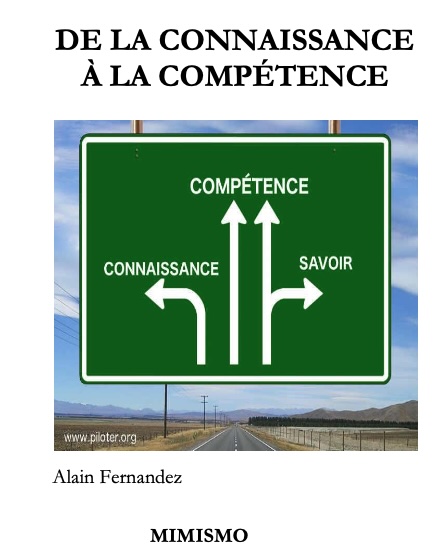

Il n'y a que des données dans les bases. Des données qu'il s'agit de collecter, de trier, de structurer, de synthétiser, de partager surtout, et là, si l'on s'y prend correctement, on fabrique quelque chose d'une valeur inestimable : la connaissance...

Tuto: Business Intelligence et méthode Gimsi

Formation gratuite à la conception du projet Business Intelligence centré tableau de bord. deuxième partie de la méthode GImsi, 3ème partie. Cette formation est une initiation, une introduction à l'ouvrage de référence : Les nouveaux tableaux de bord des managers : -

![]()

C'est en effet l'unique moyen de parvenir à une indispensable intelligence collective tout en répondant aux attentes des salariés qui pour la large majorité ne supporte plus d'être considéré comme un centre de coût, réduit "au mieux" à la portion congrue des succès.

Pourquoi oublie-t-on si facilement que ce sont eux les véritables créateurs de valeurs de l'entreprise ?

Dans cette étude, nous verrons comment bâtir concrètement avec exemples à l'appui une gouvernance coopérative digne de ce nom.

La transformation démocratique de l'entreprise

La transformation démocratique de l'entreprise

Pour en finir avec le mépris, principe délétère du management d'hier et d'aujourd'hui

Auteur : Alain Fernandez

Sujet : Une étude méthodique et illustrée d'implantation d'une gouvernance coopérative au sein d'une entreprise industrielle

Pages : 360 pages

ISBN : 978-2959320422

Dispo : Cliquez sur l'image

L’auteur

Alain Fernandez est un spécialiste de la mesure de la performance, de l’aide à la décision et de la conception de tableaux de bord de pilotage. Au fil de ces vingt dernières années, il a conduit de nombreux projets de réalisation de système décisionnel en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités.

Alain Fernandez est un spécialiste de la mesure de la performance, de l’aide à la décision et de la conception de tableaux de bord de pilotage. Au fil de ces vingt dernières années, il a conduit de nombreux projets de réalisation de système décisionnel en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités. À ce sujet, voir aussi

À ce sujet, voir aussi

Qu'est-ce que le Text Mining ?

Qu'est-ce que le Text Mining ?

Définition et outils de Text Mining, un premier exemple historique pour bien comprendre l'importance d'extraire le sens de documents non structurés, suivi d'un second exemple bien plus récent où cette idée d'extraire des résumés synthétiques pour créer des documents d'intérêts en automatique prend tournure sur le web pour au final construire une wikipedia bis entièrement automatiquement. Qu'est-ce qu'un arbre de décision ?

Qu'est-ce qu'un arbre de décision ?

Qu'est ce qu'un arbre de decision ? Comment le bâtir, comment l'utiliser, quelles en sont les variantes ? Méthodes et outils d'analyse de la Business Intelligence. Analyse prédictive et réseau de neurones, définition

Analyse prédictive et réseau de neurones, définition

Analyse prédictive et réseau de neurones Méthodes et outils d'analyse de la Business Intelligence.

Livre de référence du site

Livre de référence du site

Les nouveaux tableaux de bord des managers

Les nouveaux tableaux de bord des managers

Le projet Business Intelligence clés en main

Alain Fernandez

6ème édition Eyrolles

468 pages

Pour acheter ce livre :

Format ebook : PDF ou ePub, Kindle

À lire aussi...

À lire aussi...

Un ouvrage assez pointu sur les techniques d'analyse quantitative des données, un livre pour les spécialistes du sujet...

Science Mining

Science Mining

Fondamentaux et études de cas : Machine learning avec Python et R

Eric Biernat, Michel Lutz

Éditions Eyrolles

294 pages

Dispo : www.amazon.fr

Un livre accessible pour mieux comprendre le principe du Big Data et du Machine Learning...

Big Data et Machine Learning

Big Data et Machine Learning

Les concepts et les outils de la data science

Pirmin Lemberger, Marc Batty, Médéric Morel, Jean-Luc Raffaëlli

Dunod 3ème édition 2019

272 pages

Dispo : www.amazon.fr

Un ouvrage en français assez intéressant pour bien saisir les techniques du datamining et les applications typiques comme le comportement des consommateurs, l'étude client ou la détection de fraudes, pour ne citer que celles-ci...

Data mining

Data mining

Découverte de connaissances dans les données

Daniel-T Larose

Vuivert 2ème éd. 2018

392 pages

Dispo : www.amazon.fr

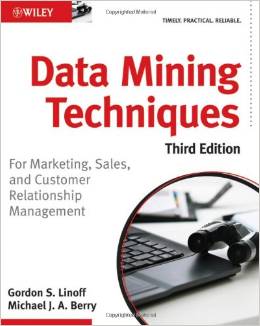

Un livre assez complet sur les techniques de data mining et les applications au marketing et à la gestion de la relation client. L'ouvrage présente les principes techniques de data mining et les outils d'analyses connexes. L'auteur en étudie les forces et les faiblesses et en précise les applications à l'aide d'exemples concrets (Livre en anglais)...

Data Mining Techniques

Data Mining Techniques

For Marketing, Sales, and Customer Relationship Management

Michael J. Berry, Gordon S. Linoff

John Wiley & Sons Ltd 3ème édition 2011

888 pages

Dispo : www.amazon.fr & Format Kindle

Un livre est associé au développement du projet de data mining libre Weka. Facile d'accès, et suffisamment documenté et explicite pour que le lecteur puisse se forger une solide connaissance de la question. Les exemples s'appuient sur le fameux outil gratuit de data mining open source Weka (Livre en anglais)...

Data Mining

Data Mining

Practical Machine Learning Tools And Techniques

I.H. Witten, Eibe Frank

Morgan Kaufmann Publishers 4ème édition

654 pages

Dispo : www.amazon.fr & Format Kindle

Points de vue

Points de vue

Piloter l'Entreprise Innovante...

Piloter l'Entreprise Innovante...

La prise de décision en équipe ne s'improvise pas. Pour parvenir à ce mode de management délégataire, crucial pour les organisations actuelles, privées comme publiques, un indispensable travail de fond prélable est nécessaire. La méthode SOCRIDE centrée sur les questions incontournables de Confiance et de Reconnaissance est ici expliquée, illustrée et détaillée :

Les tableaux de bord du manager innovant

Les tableaux de bord du manager innovant

Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Alain Fernandez

Éditeur : Eyrolles

Pages : 320 pages

![]() Consultez la fiche technique »»»

Consultez la fiche technique »»»

Pour acheter ce livre :

Format ebook : PDF & ePub,

Format Kindle

Voir aussi...

Partagez cet article...

Partagez cet article...

(total partages cumulés > 105)

Pour approfondir

Un Bonheur Imaginaire

Décider en équipe

Tableau de bord DIY

Le système décisionnel

Bonnes pratiques projet

De salarié à entrepreneur

Astuces Entrepreneur

PDF Management

Les plus lus...

1. Modélisation du data warehouse, le schéma en étoile

1. Modélisation du data warehouse, le schéma en étoile 3. Business Intelligence, Architecture du SID

Écrit par : Sergine

parce que c'était pas son boulot. Sa prestation ne portait pas sur cet aspect des choses. Voilà à mon avis Marc

Écrit par : Marc

Je reviens avec une nouvelle question : Avez-vous idée de quelles sont les méthodes les plus appropriées pour bien délimiter les données en terme de bases-sources et bien sûr de données-sources au sein de ces bases ? J'ai d'autres questions à propos des techniques de consolidation de données de sources différentes mais on verra plus tard. En tout cas merci d'avance.

Écrit par : Philippe Davout

Votre article met en évidence la nécessité de ne pas uniquement se focaliser sur la partie technique, et que l'accompagnement marketing des outils DM est très important. Cordialement, P. Pour aller plus loin : http://dataminer.unblog.fr

Écrit par : Pascal Bizzari