- ▶ Management de l'entreprise ▶ Management Démocratique

- Conception de la stratégie

- Principes de gouvernance

- La Performance des métier

- Le contrôle de gestion

- ▶ Innover en équipe

- L'Innovation et la Performance

- L'Innovation Managériale

- La Méthode SOCRIDE

- ▶ Décider au quotidien

- Le processus de Décision

- La Décision en équipe

- Les Techniques de décision

- ▶ Guide gratuit de l'Autoformation

- Méthode d'autoformation

- Les 7 Qualités pour réussir

- Comment s'auto-évaluer ?

- ▶ Formation Gratuite Management

- Formation tableau de bord et BI

- Formation Management de Projet

- Formation Entrepreneuriat

- ▶ ebook et PDF management gratuits

- ▶ PDF Entrepreneuriat

- ▶ ebook Perfonomique

Qu'est-ce que le Big Data ? Définition et Principe

- Définition du Big Date

- 3V+1 Volume, Vélocité, Variété et Valeur

- Analyse des données

- Data Scientist

- Machine Learning

- Qu'est-ce qu'un algorithme ? Définition

- Technologies du Big Data

- Ressources

Définition du Big Data

- Big Data

-

Ce terme englobe un ensemble de technologies, de méthodes et pratiques bien spécifiques pour stocker et analyser (rapidement) de très grandes masses de données avant d'en tirer des enseignements.

Autrement dit, il s'agit de construire des modèles destinés à mieux comprendre des phénomènes et des comportements insaisissables jusqu'alors. Le Big data data bouscule de fond en comble nos manières de faire du "business".

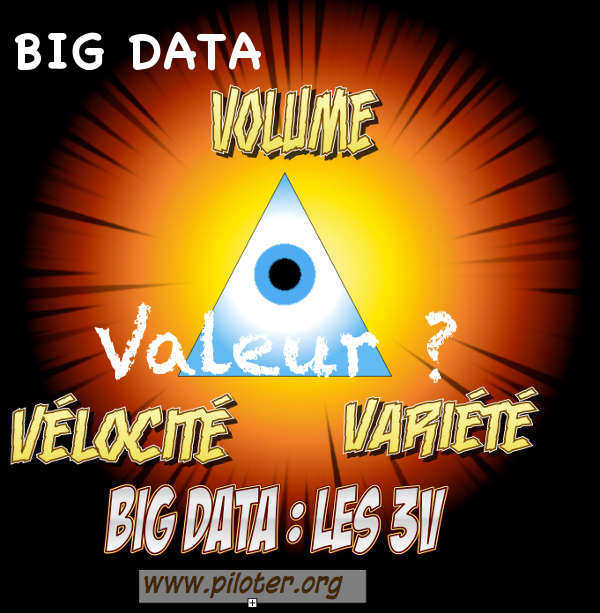

Volume + Vélocité + Variété et Valeur

Pour décrire le principe du big data, il est coutumier de résumer ses caractéristiques majeures en utilisant 3 lettres "V" :Volume, Vélocité, Variété

3 "V" auxquels nous ajouterons un quatrième "V" pour la notion de "Valeur" qui est quand même bien le but de l'opération, et donc de l'investissement.

-

"V" pour Volume

La quantité de données générée est en pleine expansion et suit une loi quasi exponentielle. Le commerce électronique et les réseaux sociaux sont les grands contributeurs de cette profusion de données. Voir notamment le stockage distribué et traitement parallèle avec le framework Hadoop. -

"V" pour Velocity (rapidité)

La rapidité de renouvellement des données dans un monde connecté n'est plus à démontrer. Toutes les nouveautés et mises à jour sont stockées en respect de la devise du big data : "On garde tout !". -

"V" pour Variety (variété)

Les bases de données spécialisées sont en mesure de gérer la multiplicité des formats des données : numérique, texte, image... Voir les bases de données NoSql Et "V" pour Valeur ?

Il n'est pas inutile d'y ajouter un quatrième "V" pour "Valeur", comme le recommandent les pragmatiques qui sont aussi les mieux avertis (ou déjà échaudés...) de la pratique des technologies de l'information. Autrement dit, il faut bien que tout cela serve à quelque chose "d'utile" et donc d'utilisable et d'utilisé.Les investissements sont nécessairement conséquents. On ne peut se satisfaire de vagues promesses ou de l'exemple cent fois rabâché de l'usage qu'en font les GAFA (Google, Amazon, Facebook, Apple), un exemple impossible à transposer dans une entreprise standard très nettement moins connectée.

Finalement, c'est quoi le Big data ?

En théorie, le big data est le moyen d'étudier de très grandes quantités de données afin d'établir des modèles originaux qui nous offriront une vision plus fine de la réalité, et nous permettrons de prendre des décisions plus pertinentes.En attendant l'internet des objets (IOT) pour collecter encore plus de données, puisque nous sommes dans une logique où l'on associe quantité à qualité de l'information...

Pourquoi le big data ? Parce que...

- 1) Le coût de la collecte des datas a chuté.

- 2) Les systèmes connectés sont en progression exponentielle (avec "système" dans son sens le plus large).

- 3) L'incertitude exige des analyses plus poussées, plus rapides et plus fréquentes.

Analyser les données

Bien évidemment, stocker une telle quantité de données n'a d'autre finalité que de tirer des enseignements pertinents afin d'accroître notre connaissance sur notre environnement professionnel en l'occurrence.Les finalités des analyses big data sont multiples. Que ce soit pour des analyses prospectives pour mieux comprendre les attentes des clients, la modélisation pour mieux fixer le prix d'une nouvelle gamme de produits selon le segment visé ou encore une simulation du type "que se passerait-il si ?", le champ d'investigation est vaste.

De la qualité des données décisionnelles

Il est impératif disposer de données utilisables si l'on souhaite bâtir des modèles décisionnels pertinents.

Pour illustrer ce propos, lire les deux articles suivants traitant de ce point essentiel :

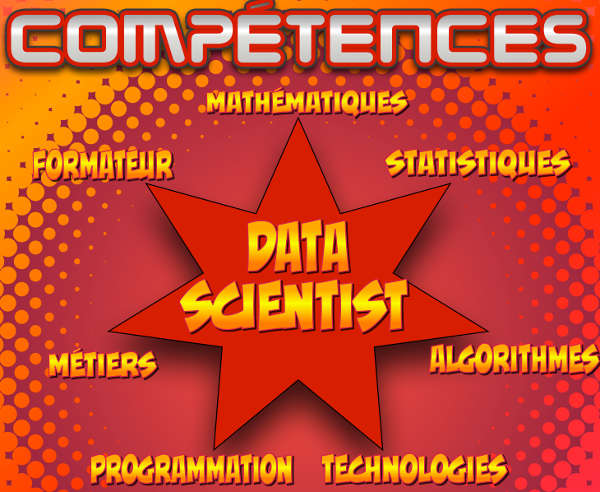

Data scientist

Le "bon" Data Scientist sait maîtriser les techniques d'analyse pour choisir les plus opportunes afin de tirer les enseignements les plus pertinents.Recherche de corrélation, analyse prospective, modélisation, simulation, data vizualisation, voilà quelques techniques que doit maîtriser le spécialiste de l'analyse des données big data, le "data scientist" que l'on pourrait traduire par le scientifique des données.

Aussi, le data scientist ne travaille pas tous azimuts. Il vise une finalité, un résultat qui correspond à un besoin de l'entreprise ou d'un manager métier. Il sélectionne les sources de données puis les données elles-mêmes et lance ses travaux d'analyses à cette fin.

Comment devenir Data Scientist ?

Si les premiers spécialistes de l'exploitation du Big Data s'étaient auto désignés ainsi, les exigences de compétences pour exercer ce métier imposent désormais une formation spécifique.

- Les mathématiques, les statistiques ainsi que les méthodes algorithmiques d'auto-apprentissage bien spécifiques pour concevoir les modèles d'étude

- La technologie informatique et la "science" de la programmation pour construire lesdits modèles et exploiter la "jungle" des données multi-formats

- Connaître les métiers de l'entreprise est aussi un impératif. Le data scientist est au service des besoins de l'entreprise, il les comprend et sait aussi expliquer les résultats obtenus, c'est un formateur.

- Paris tech par exemple : Master spécialisé Gestion et analyse de données massives

- ou bien: Grenoble Ecole de Management

- ou encore : ENSAI et son master international

Machine Learning

Le principal intérêt du Big Data est bien de profiter d'une masse impressionnante de données pour tenter de prédire des comportements tels que les tentatives de fraudes, ou de mieux anticiper les risques de défaut de paiement ou de remboursement. Ce ne sont là que deux exemples parmi tant d'autres.Ce sont les algorithmes de Machine Learning, ou d'apprentissage automatique en français, qui vont nous aider à mieux étudier ces risques ou opportunités, le cas échéant, afin de mieux les anticiper.

... et bien décoder les résultats sans se laisser emporter par son enthousiasme à l'interprétation de corrélations aberrantes.

- Les cinq caractéristiques d'un bon algorithme de machine Learning selon Ted Dunning expert chez MapR

- Causalité n'est pas corrélation

Qu'est qu'un algorithme ? Définition

- Algorithme

- Selon la presse généraliste, le terme « algorithme » semble désigner aujourd'hui d'énigmatiques systèmes informatiques d'ultime génération, dotés d'une capacité d'apprentissage infinie qui leur conféreraient un pouvoir omniscient quasi magique.

Ces « algorithmes » au fonctionnement ésotérique pour le commun des mortels, véritables entités pensantes, seraient en passe de nous dominer et de nous reléguer, nous autres insignifiantes créatures humaines, à quelque chose d'anachronique dans une cyber société ultra-libérale régnante...

Espérons que tout cela s'achève mieux pour nous que pour les personnages des dystopies !Cela dit, la crainte d'accorder un pouvoir inconsidéré aux systèmes d'intelligence artificielle toujours plus autonomes, sans régulation ni débat éthique officiel, est aujourd'hui pleinement justifiée !

Sinon, pour mémoire, le terme « d'algorithme » désigne à l'origine un enchaînement d'opérations pour exécuter un calcul, et par extension une tâche précise, informatisée ou non.

L'algorithme d'Euclide pour trouver le plus grand commun diviseur (PGCD) en est l'exemple le plus classique.

Technologies du big data

Le coût des technologies a drastiquement chuté. La mise en oeuvre des solutions de stockage et de traitements, massivement "parallélisée" pour traiter les "grandes" données, est aujourd'hui tout à fait à la portée de bien des entreprises qui souhaitent investir dans une technologie de ce type.La majorité des logiciels de base sont de surcroît disponibles en open-source. Le "cloud computing" a dynamisé l'essor du Big Data en proposant des systèmes de stockage "à la carte" avec un tuning fin des capacités toujours en phase avec les besoins pour un coût abordable (rien à voir avec le même équipement en mode "propriétaire").

Pour autant, comme c'est d'ailleurs le cas pour tous les projets technologiques, rien n'est gratuit et la démarche Big Data doit s'inscrire dans un schéma plus globale, en conformité avec les objectifs stratégiques de l'entreprise.

Les sources de données

Lorsque l'on aborde le sujet du Big Data, on nous ressasse toujours l'exemple des géants de l'Internet qui exploitent avec talent le web, les réseaux sociaux et la géo-localisation. Dans la réalité, la majorité des entreprises se contentent de traiter les données provenant de "sources plus classiques" : ERP et CRM. Ces sources sont riches d'informations, n'en doutons pas.Mais hormis la minorité d'entreprises qui gèrent un commerce en ligne (B2C, B2B), elles sont encore peu nombreuses à s'ouvrir sur l'extérieur, en achetant des accès à des bases de données externes ou en exploitant l'Open Data par exemple.

Bien du chemin reste encore à parcourir, notamment avec une plus large exploitation des objets connectés. Ils seront rapidement indispensables pour optimiser au mieux les solutions de supply-chain.

Ressources web

Ressources web

- De très nombreuses ressources d'intérêt à propos de la Data : smartdatacollective

- L'Open data mis en place par le gouvernement français donnant accès aux données publiques : www.data.gouv.fr

- Il est intéressant de noter que les grandes sociétés et les services publics répondent aux besoins des concepteurs de services, telle la SNCF qui propose un accès à tous les itinéraires et horaires de train en temps réel : data.sncf.com

- Ou encore le ministère de l'enseignement et de la recherche avec : data.enseignementsup-recherche.gouv.fr

- Un bon article de Sciences et Avenir à propos du devenir du "deep learning", concept clé de l'intelligence artificielle et de l'auto-apprentissage, étroitement lié à la conception d'algorithme d'exploitation massive des données : Deep learning, sciences et avenir

Pour approfondir le sujet...

Pour approfondir le sujet...

La technologie mise en oeuvre pour le Big Data

La technologie mise en oeuvre pour le Big Data

Les technologies qui permettent de bâtir une solution de type Big Data ou Données Massives en français, ont leur origine au sein même des moteurs de recherche du web.

Formation au Big Data pour Managers

Formation au Big Data pour Managers

Un guide d'auto-formation pour les managers décideurs en matière de technologie d'entreprise afin d'apporter les bases suffisantes pour effectuer des choix d'opportunités technologiques en toute conscience. Le big data et la décision en entreprise

Le big data et la décision en entreprise

Faciliter la prise de décision lorsque l'on évolue au sein d'un environnement ultra concurrentiel, et donc incertain et changeant, est une gageure. Questions autour du Big Data

Questions autour du Big Data

Quoi, Pourquoi, Comment ? Une manière de "digest" pour les lecteurs pressés, le big data expliqué au manager décideur en 3 questions/réponses. La technologie mise en oeuvre pour le Big Data

La technologie mise en oeuvre pour le Big Data

Les technologies qui permettent de bâtir une solution de type Big Data ont leur origine au sein même des moteurs de recherche du web. Définition Hadoop

Définition Hadoop

Hadoop est un projet Open Source géré par Apache Software Fundation basé sur le principe Map Reduce et Google File System, deux produits Google Corp. Le produit est écrit en langage Java. MapReduce, définition

MapReduce, définition

Qu'est-ce que MapReduce ? Définition de Mapreduce de Google Corp. Mapreduce est un modèle de programmation massivement parallèle adapté au traitement de très grandes quantités de données. Les Bases de données NoSQL, principe

Les Bases de données NoSQL, principe

Les bases de données relationnelles très largement utilisées par les entreprises ne sont pas les mieux adaptées aux exigences des analyses complexes et rapides. Les besoins de redondance indispensables aux calculs massivement parallèles tout comme la tolérance aux pannes exigent une nouvelle structure de bases de données. Les bases de données In-Memory

Les bases de données In-Memory

Un point à propos des nouvelles solutions de bases de données résidentes en mémoire vive pour accélérer les traitements et juger des résultats sans attendre trop longtemps. Le marketing du Big Data, les vendeurs d'illusions

Le marketing du Big Data, les vendeurs d'illusions

Le marketing et son storytelling sont déjà "en marche" pour colporter les nouvelles chansons de gestes contant les succès fabuleux des solutions d'analytique. Il est prudent de décoder le storytelling marketing... Une critique du Big Data

Une critique du Big Data

Le Big Data est une révolution en soi, aucun doute à ce sujet. Cela dit, en pratique, il ne faut pas non plus dire et faire n'importe quoi. Il est raisonnable de compenser l'enthousiasme des uns d'un regard critique. Quelles sont les limites du Big Data et de l'Analytique ?

Quelles sont les limites du Big Data et de l'Analytique ?

Le Big Data offre bien des avantages sur le papier. Dans la réalité, le Big Data n'est pas exempt de limites qu'il s'agit de bien connaître avant même d'envisager de s'engager dans une solution technologique de ce type. Meilleurs livres Big Data

Meilleurs livres Big Data

Sept ouvrages pour bien comprendre les principes et les enjeux destinés aux managers qui souhaitent se forger un solide bagage intellectuel sur la question afin de prendre les décisions d'orientation les plus raisonnables.

Comment devrait doit être le management actuel...

Le thème:

Le thème:Instaurer la démocratie en entreprise

Au programme:

Sujet : Expérience concrète d'instauration de la démocratie au sein d'une PME

ISBN : 9782959320422

Pages : 360 pages

Dispo :

![]() Présentation détaillée du livre "la transformation démocratique de l'entreprise"

Présentation détaillée du livre "la transformation démocratique de l'entreprise"

À lire...

À lire...

1. Un ouvrage clair et précis pour aborder la question du big data et du Machine Learning.Bien qu'il soit sous-titré aux légitimes fins commerciales "Le guide du Data Scientist", ce livre est à mon avis plutôt destiné aux responsables techniques, les DSI par exemple pour ne citer que ceux-ci.

Ils l'utiliseront comme un outil d'auto-formation et seront mieux armés pour piloter le projet, ou plus simplement pour envisager son éventualité dans les meilleurs conditions...

Big Data et Machine Learning

Big Data et Machine Learning

Les concepts et les outils de la data science

Pirmin Lemberger, Marc Batty, Médéric Morel, Jean-Luc Raffaëlli

Dunod 3ème édition 2019

272 pages

Dispo : www.amazon.fr

2. Un deuxième ouvrage pratique pour mieux comprendre et exploiter les ressources du Big Data. Ce thème est nécessairement très technique et s'adresse aux professionnel-les maîtrisant un tant soit peu la programmation et impérativement l'outil statistique.

Pour les débutants qui souhaitent une vision plus généraliste, il est préférable de se reporter aux ouvrages 4 et 5 de cette liste...

Data science : Fondamentaux et études de cas

Data science : Fondamentaux et études de cas

Machine Learning avec Python et R

Éric Biernat, Michel Lutz

Eyrolles

272 pages

Dispo :

www.amazon.fr & Format Kindle

3. Un livre court mais précis pour résister aux mythe et mieux comprendre la réalité et les enjeux du Big Data et du "monde des algorithmes"...

À quoi rêvent les algorithmes

À quoi rêvent les algorithmes

Nos vies à l'heure des big data

Dominique Cardon

La république des idées

105 pages

Dispo :

www.amazon.fr

- Voir ici une critique plus complète : Bigdata, algorithme, données... et nous alors ?

4. Une bonne introduction au Big Data. Les auteurs exposent dans un langage clair toutes les facettes de la problématique et dessinent les perspectives et les mutations qui nous attendent déjà. Ce livre est un best-seller de sa catégorie aux États-Unis...

Big Data

Big Data

La révolution des données est en marche

Kenneth Cukier, Viktor Mayer-Schoenberger

Robert Laffont

296 pages

5. La référence du processus décisionnel en entreprise. L'ouvrage de référence auprès des managers, consultants, chefs de projets décisionnels, formateurs et enseignants...

Les nouveaux tableaux de bord des managers

Les nouveaux tableaux de bord des managers

Le projet Business Intelligence clés en main

Alain Fernandez

6ème édition Eyrolles

468 pages

Pour acheter ce livre :

Format ebook : PDF ou ePub, Kindle

Piloter l'Entreprise Innovante...

Piloter l'Entreprise Innovante...

De l'importance de réformer les principes archaïques de contrôle de la mesure de la performance pour enfin dynamiser la prise de décision en équipe, incontournable clé de l'entreprise innovante. La méthode SOCRIDE centrée sur les questions de Confiance et de Reconnaissance est ici expliquée, illustrée et détaillée :

Les tableaux de bord du manager innovant

Les tableaux de bord du manager innovant

Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Alain Fernandez

Éditeur : Eyrolles

Pages : 320 pages

![]() Consultez la fiche technique »»»

Consultez la fiche technique »»»

Pour acheter ce livre :

Format ebook : PDF & ePub,

Format Kindle

Voir aussi...

Le mot du jour

BonheurDu jour où je parvins à me persuader que je n'avais pas besoin d'être heureux, commença d'habiter en moi le bonheur.

André Gide

Partagez cet article...

Partagez cet article...

(total partages cumulés > 185)

Ouvrages du même auteur

Réformer le management

Perfonomique

Décider en équipe

Tableau de bord DIY

Bonnes pratiques projet

Le système décisionnel

De salarié à entrepreneur

Astuces Entrepreneur

Ebook autoformation

PDF Management

Les plus lus...

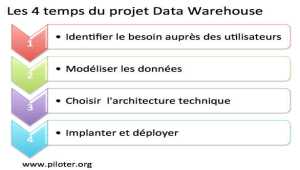

1. Le projet Data Warehouse, un processus continu

1. Le projet Data Warehouse, un processus continu 3. Business Intelligence Open Source, principe et produits